Trong thế giới của khai thác dữ liệu web (web data extraction), việc theo kịp các phương pháp mới nhằm ngăn chặn hành vi thu thập dữ liệu tự động (scraping) thường là điều không dễ dàng. Đó chính là lúc proxy dành cho web scraping trở nên hữu ích. Hướng dẫn này sẽ cho bạn thấy cách những máy chủ proxy này có thể trở thành “công cụ bí mật” giúp bạn dễ dàng thu thập dữ liệu web cần thiết. Bằng việc sử dụng proxy cho web scraping, bạn có thể thực sự nâng cao khả năng thu thập dữ liệu và đưa dự án của mình lên một tầm cao mới.

Hiểu về Proxy cho Web Scraping

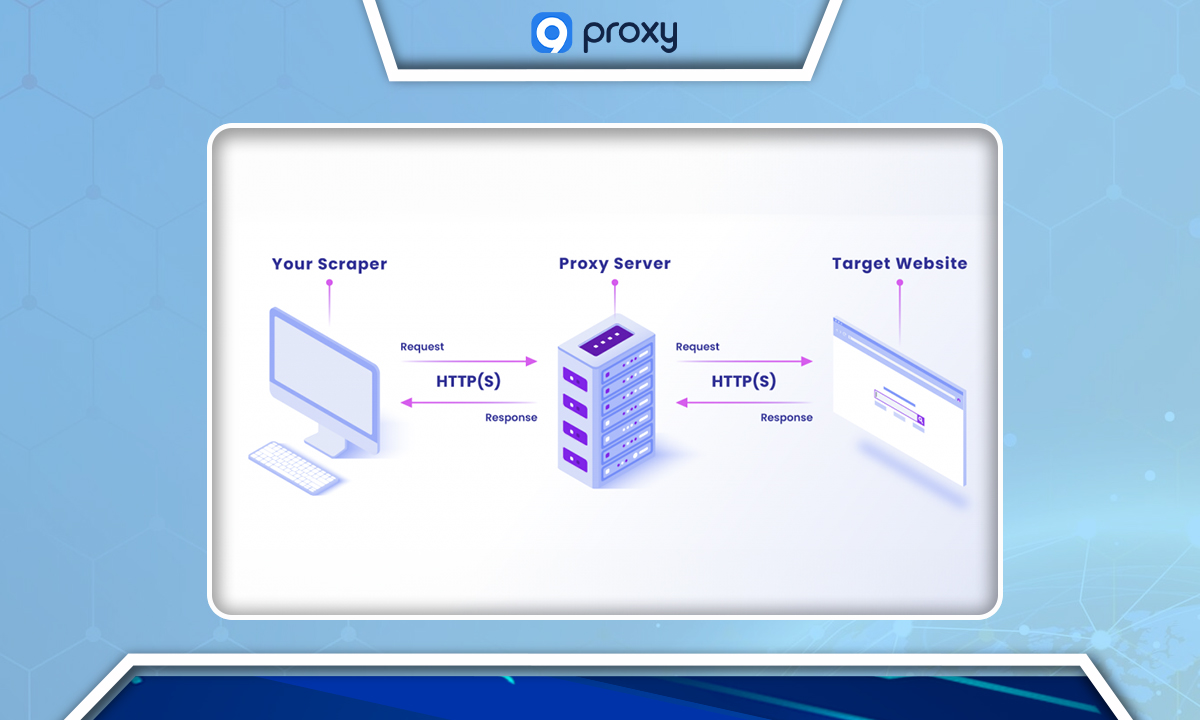

Máy chủ proxy (proxy server) là một công cụ hoạt động như trung gian giữa máy tính của bạn và Internet. Khi bạn thực hiện web scraping, tức là tự động thu thập dữ liệu từ các trang web, proxy sẽ gửi yêu cầu thay cho bạn, giúp ẩn danh tính thật của máy tính trước trang web đích. Điều này không chỉ hữu ích cho việc bảo mật quyền riêng tư mà còn giúp tránh bị các trang web chặn bằng những biện pháp chống scraping.

Các giao thức Proxy cho Web Scraping

Có hai loại giao thức proxy chính: HTTP và SOCKS.

- HTTP proxy là loại phổ biến hơn, dễ dàng tích hợp với các công cụ duyệt web, nên thường được sử dụng trong hầu hết các hoạt động web scraping.

- SOCKS proxy, ngược lại, thường nhanh hơn, ổn định hơn và bảo mật tốt hơn. Chúng rất phù hợp cho các tác vụ scraping phức tạp, nơi tốc độ và độ ổn định là yếu tố then chốt.

Các loại Proxy dùng cho Web Scraping

Khi tiến hành web scraping, việc lựa chọn loại proxy phù hợp đóng vai trò quyết định hiệu quả và độ tin cậy trong quá trình thu thập dữ liệu. Dưới đây là tổng quan các loại proxy phổ biến:

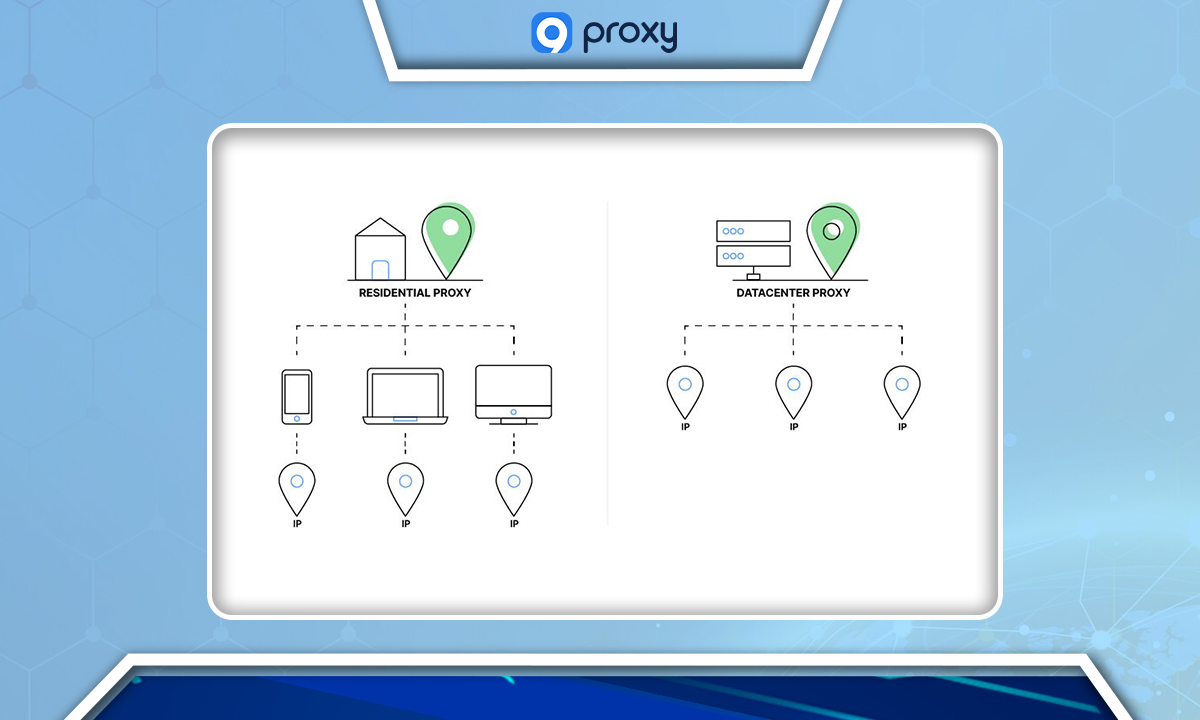

Residential Proxies (Proxy dân cư)

Loại proxy này sử dụng địa chỉ IP được cung cấp bởi các nhà cung cấp dịch vụ Internet (ISP), khiến chúng trông giống như truy cập từ một kết nối Internet gia đình thông thường. Nhờ hòa trộn với lưu lượng người dùng thật, proxy dân cư rất phù hợp khi truy cập các trang có biện pháp bảo mật nghiêm ngặt, giúp giảm thiểu rủi ro bị phát hiện hoặc chặn.

Datacenter Proxies (Proxy trung tâm dữ liệu)

Datacenter proxies cung cấp IP từ các trung tâm dữ liệu và không liên kết với ISP. Chúng được đánh giá cao vì tốc độ nhanh và chi phí thấp. Tuy nhiên, do không mang tính “dân cư”, nên chúng dễ bị phát hiện hơn, nhưng lại hiệu quả trong các tác vụ cần thu thập dữ liệu số lượng lớn, nhanh chóng, nơi trang web không quá gắt gao về bảo mật.

Rotating Proxies (Proxy xoay)

Rotating proxies tự động thay đổi địa chỉ IP của bạn theo khoảng thời gian định kỳ hoặc với mỗi yêu cầu mới. Việc thay đổi IP liên tục này khiến các trang web khó theo dõi và chặn hoạt động scraping, là giải pháp hiệu quả để đối phó với các hệ thống chống bot mạnh.

Dedicated Proxies (Proxy riêng tư)

Dedicated proxies là proxy riêng cho một người dùng duy nhất. Chúng mang lại trải nghiệm scraping ổn định và đáng tin cậy, đồng thời giảm thiểu nguy cơ bị chặn, vì uy tín IP (IP reputation) luôn được duy trì ổn định. Đây là lựa chọn lý tưởng cho các dự án dài hạn yêu cầu tính bền vững.

Shared Proxies (Proxy chia sẻ)

Đây là loại proxy được nhiều người dùng sử dụng cùng lúc, và là phương án tiết kiệm chi phí nhất. Tuy nhiên, do dùng chung, rủi ro bị liệt vào danh sách đen (blacklist) cao hơn. Chúng phù hợp với các tác vụ scraping nhẹ hoặc khi ngân sách hạn chế.

Tại sao nên sử dụng Proxy khi Web Scraping?

Việc sử dụng proxy server khi thu thập dữ liệu web mang lại rất nhiều lợi ích quan trọng:

- Ẩn danh và bảo mật: Proxy giúp che giấu địa chỉ IP thật của bạn, ngăn các trang web phát hiện và chặn hoạt động scraping. Lớp bảo mật này giúp bạn an toàn hơn, có thể truy cập và thu thập dữ liệu mà không lộ danh tính.

- Tránh bị chặn và cấm truy cập:Proxy cho phép bạn luân chuyển yêu cầu qua nhiều địa chỉ IP khác nhau, giúp vượt qua giới hạn hoặc lệnh cấm mà trang web áp đặt lên bot. Điều này đặc biệt quan trọng khi bạn làm việc với các trang web có hệ thống phát hiện scraping tinh vi.

- Tính linh hoạt về địa lý: Proxy có thể giả lập truy cập từ các vị trí địa lý khác nhau, rất hữu ích khi bạn cần xem nội dung theo vùng, ví dụ như giá sản phẩm hoặc hàng hóa theo quốc gia.

- Tăng quyền riêng tư và khả năng kiểm soát: Khi IP của bạn được ẩn, bạn có thêm một lớp bảo vệ riêng tư. Nếu sử dụng proxy nội bộ (in-house), bạn còn có toàn quyền kiểm soát quy trình scraping, đảm bảo bảo mật dữ liệu và giúp đội kỹ thuật quản lý hiệu quả hơn.

- Vượt qua hạn chế nội dung: Proxy giúp bỏ qua giới hạn truy cập nội dung, bao gồm cả giới hạn theo khu vực địa lý, giúp bạn tiếp cận được nội dung bị chặn theo quốc gia.

Cách chọn Proxy phù hợp cho Web Scraping

Việc lựa chọn proxy phù hợp có thể quyết định thành công của quá trình thu thập dữ liệu. Dưới đây là các yếu tố bạn cần xem xét:

- Loại proxy: Hiểu rõ từng loại, residential, datacenter, rotating, dedicated, và shared, để chọn đúng loại phù hợp với nhu cầu scraping.

- Bảo mật và độ tin cậy: Chọn những proxy có tính năng bảo mật mạnh, ví dụ mã hóa dữ liệu (encryption). Độ tin cậy cũng quan trọng không kém, proxy nên có thời gian hoạt động ổn định, ít gián đoạn.

- Chi phí và ngân sách: Ngân sách của bạn sẽ ảnh hưởng đến lựa chọn. Proxy miễn phí thường chậm và kém ổn định, trong khi proxy trả phí mang lại hiệu suất và hỗ trợ tốt hơn. Hãy cân đối giữa chi phí và chất lượng dịch vụ.

- Tương thích với công cụ scraping: Proxy phải tích hợp mượt mà với phần mềm hoặc script scraping của bạn. Nếu có vấn đề tương thích, hiệu quả thu thập dữ liệu sẽ giảm.

- Tốc độ và hiệu năng: Tốc độ proxy cực kỳ quan trọng, proxy chậm có thể gây timeout hoặc làm trễ việc thu thập dữ liệu. Hãy kiểm tra tốc độ proxy trước khi quyết định sử dụng lâu dài.

Các công cụ hỗ trợ Web Scraping qua Proxy

Dưới đây là một số công cụ phổ biến giúp bạn thực hiện và quản lý scraping hiệu quả khi dùng proxy:

Selenium

Bộ công cụ tự động hóa trình duyệt web, cho phép mô phỏng hành vi người dùng thực tế. Rất hữu ích cho các tác vụ scraping phức tạp. Selenium có thể cấu hình làm việc với proxy, giúp bạn duy trì tính ẩn danh khi scraping.

Scrapy

Một framework mã nguồn mở bằng Python được thiết kế riêng cho việc thu thập dữ liệu web. Scrapy hỗ trợ quản lý proxy, xử lý nhiều loại yêu cầu và cơ chế chống scraping, khiến nó trở thành lựa chọn mạnh mẽ cho các dự án lớn.

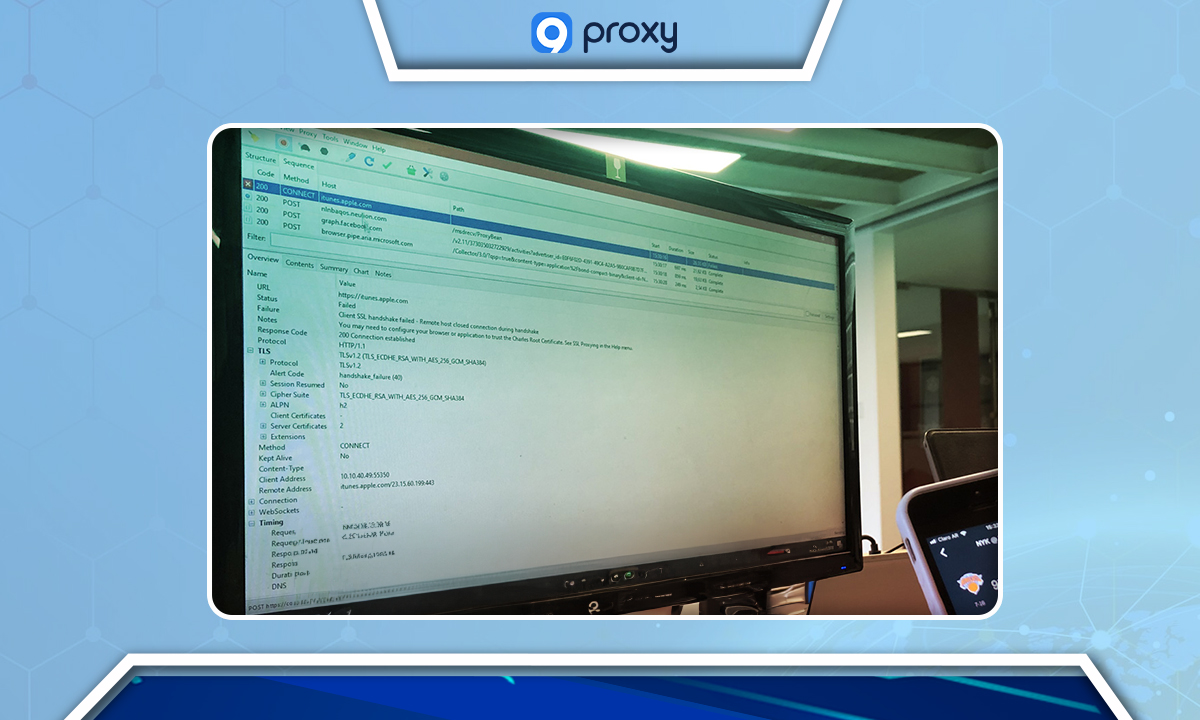

Charles Proxy

Là một công cụ HTTP proxy / HTTP monitor / Reverse Proxy, giúp lập trình viên xem toàn bộ lưu lượng HTTP và HTTPS giữa máy tính và Internet, bao gồm cả yêu cầu, phản hồi và header (cookies, cache, v.v.). Rất hữu ích khi kiểm thử và gỡ lỗi (debug) các công cụ web scraping.

Proxy Checker

Là công cụ độc lập giúp kiểm tra và đánh giá proxy, có thể test nhiều proxy cùng lúc và cung cấp thông tin về tốc độ, độ ẩn danh, hỗ trợ bạn chọn ra proxy tốt nhất cho dự án scraping.

Câu hỏi thường gặp (FAQ)

Cần bao nhiêu proxy cho một dự án web scraping?

Số lượng phụ thuộc vào khối lượng yêu cầu và giới hạn của trang web đích. Một cách tính phổ biến: chia tổng số yêu cầu mỗi giờ cho 500 để ước tính số lượng proxy cần thiết.Với các dự án quy mô lớn, thường cần nhiều proxy để mô phỏng hành vi truy cập tự nhiên và tránh bị phát hiện.

Proxy ảnh hưởng như thế nào đến tốc độ scraping?

Proxy có thể tác động đến tốc độ. Proxy trả phí chất lượng cao thường có tốc độ nhanh và ổn định hơn, trong khi proxy miễn phí hoặc chất lượng thấp dễ gây chậm trễ hoặc nghẽn kết nối do nhiều người cùng sử dụng.

Có thể dùng VPN thay cho proxy để web scraping không?

VPN có thể thay đổi IP tương tự proxy, nhưng thiếu tính linh hoạt trong xoay vòng IP (IP rotation) và quản lý nhiều IP cùng lúc. Proxy cung cấp mức độ kiểm soát chi tiết hơn, rất quan trọng cho scraping quy mô lớn và hiệu quả.

Kết luận

Trong lĩnh vực thu thập dữ liệu web chi tiết, proxy cho web scraping là người cộng sự không thể thiếu, giúp bạn vượt qua các lớp phòng thủ kỹ thuật số của Internet. Với những kiến thức từ hướng dẫn này, bạn đã sẵn sàng lựa chọn và sử dụng proxy phù hợp, biến quá trình web scraping của mình vừa hiệu quả vừa kín đáo. Khi bạn chuyển đổi dữ liệu thành thông tin giá trị, hãy nhớ rằng đây chỉ là bước khởi đầu. Hãy khám phá thêm về proxy và nâng cao kỹ năng scraping của bạn bằng cách đọc thêm các bài viết chuyên sâu từ 9Proxy.